现在啥游戏好玩(现在啥游戏好玩人多)

alicucu 2026-01-17 14:59 1 浏览

1、《剑网3:指尖江湖》

指尖江湖这是一款二次元武侠多角色游戏,游戏画面精美,自由度高。

2、《太极熊猫2》

在游戏中会有全新的游戏登场,玩家们可以尽情感受新英雄的魅力。

3、《龙之谷2》

游戏整体是以清新萌系的画风呈现。

4、《末日方舟》

末日方舟这是一款以生存策略为主题的体验类游戏,游戏剧情恐怖又紧张。

5、《二战狙击》

二战狙击这是一款国内二战写实抗战题材FPS游戏,游戏真实的还原了世界第二次大战。

6、《永恒修仙》

永恒修仙这是一款随心佛系的放置类修仙游戏,这款游戏将帮助玩家们圆修仙梦。

7、《真·三国无双 霸》

真·三国无双 霸这是一款正统真三国无双游戏,游戏还原了三国的经典剧情。

8、《斗破苍穹:斗帝之路》

帝之路这是一款大型沉浸式3DMMORPG游戏,

9、《剑侠世界2》

剑侠世界2这是一款精品武侠MMORPG游戏,游戏中含有十大唯美场景曝光给玩家们带来视觉盛宴。

10、《斗罗大陆2绝世唐门》

斗罗大陆2绝世唐门这是一款3D开

1、《原神》

原神虽然看起来是一个单机游戏,只能一个人在游戏世界里探索,但是原神其实是一款网络游戏,而且还支持好友之间联机。原神是一款二次元开放世界的手游,游戏世界非常宏大,四季景观一应俱全,还有各种妖怪,满足大家的探索欲望和战斗欲望。

2、《金铲铲之战》

金铲铲之战是云顶之弈的手游版本,在游戏里大家化身一个个可爱的小小英雄,通过构思下棋的思路和运营方式,组建出属于自己的最强阵容,打败各路弈士,还可以和其他玩家交流心得,博采众长,丰富自己的棋路。

相关推荐

- 杀戮之塔手机版(杀戮之塔种子码)

-

方法与步骤:1.首先,杀戮尖塔分为多种角色,不同角色的卡牌套装是不一样的,所以选择好你要操作的角色。2.接着是卡牌总类,卡牌分为4种,一种是有颜色的牌是主牌,灰色牌比颜色牌强大一点,还有诅咒牌和状态牌...

-

- 最新最好玩的手游排行榜(最新最好玩的手游有哪些)

-

吃鸡..王者荣耀十大手游APP排行榜,2019最热门的手游软件推荐:1、绝地求生大吉大利,今晚刺激!绝地求生:刺激战场是一款腾讯旗下光子工作室研发的绝地求生正版手游,完美还原端游的纯正游戏体验。虚幻4引擎研发,次世代完美画质,重现端游视听感...

-

2026-01-17 16:12 alicucu

- 新开传奇手游发布网(新版传奇手游发布网)

-

传奇世界手游一般十五天左右的时间开一个新区。传奇世界手游于1月9日11:00开启4组服务器!【新服信息】安卓微信1区【开天】安卓微信2区【逐日】安卓QQ1区【辟地】安卓QQ2区【奔月】...

- 三国可脱身服全去掉的游戏(三国游戏美女cos)

-

关云长单刀赴会,是三国演义中较为精彩们篇章。其时刘备己夺取了西川,按照当初在三江口对鲁肃的承诺,刘备应将荆州归还东吴,但诸葛亮推到关羽身上,让鲁肃找关公,因此鲁肃设宴请关羽,准备先礼后兵,先劝说关羽,...

- 使命召唤10剧情攻略(使命召唤10任务攻略)

-

被洛克关进了地牢结局是恶棍洛克没有死,主人公被洛克抓住了。《老兵》还有一个五秒钟的情节,主角被关在地牢里,但并没有死。第二部分应该有所暗示。洛根被洛克看上了,在关卡中洛克就对洛根说过:“你和我有很多相...

- 拳皇mugen变态版(拳皇mugen整合大全)

-

在CMD哩面改D=下B=后F=前U=上(一定要汏写)x=轻拳y=重拳C=一般是闪a=轻脚b=重脚Z=一般为吹飞记得改嘚时候前面要家“~”如kyo嘚无式:~D,DF,F,...

- 现在啥游戏好玩(现在啥游戏好玩人多)

-

1、《剑网3:指尖江湖》指尖江湖这是一款二次元武侠多角色游戏,游戏画面精美,自由度高。2、《太极熊猫2》在游戏中会有全新的游戏登场,玩家们可以尽情感受新英雄的魅力。3、《龙之谷2》游戏整体是以清新萌系...

- 手机游戏下载安装(手游app下载安装)

-

要下载和安装手机游戏到手机上,首先需要打开手机的应用商店,如苹果商店、谷歌商店或华为商店等。在搜索栏中输入想要下载的游戏名称,点击搜索后,找到对应游戏并点击下载按钮。下载完成后,应用商店会自动开始安装...

- konami实况足球官网(konami实况足球手游官网)

-

非常好玩,可以说是目前最好玩的足球经理游戏之一。如果你喜欢玩足球经理类的游戏,那就玩吧,保证不后悔。与其他优秀的足球经理类游戏相比,它的优点:1、可以随时与其他玩家的球队对战,时间由你掌握,不需等到每...

- 适合联机玩的手机游戏(最适合联机的游戏)

-

1.有很多手机游戏可以两个人联机玩,比如《王者荣耀》、《阴阳师》、《和平精英》等等。2.这些游戏都提供了多人联机的功能,可以和朋友一起组队对战或合作完成任务,增加了游戏的趣味性和挑战性。3.此外...

- 正当防卫2免费下载(正当防卫免费下载安装)

-

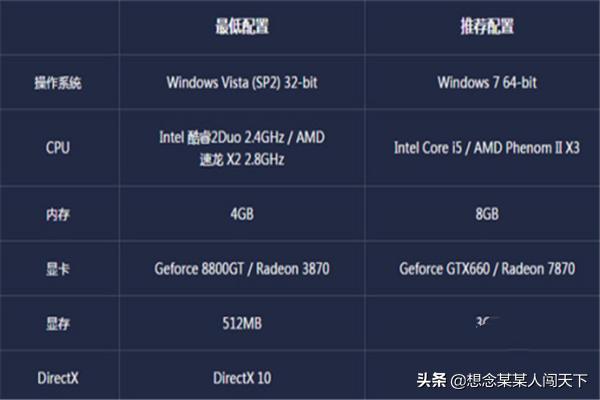

硬件最低配置推荐配置CPUAthlon64X24200/3GHzPentiumDAMDPhenomX32.4GHz/IntelCore2Duo2.6GHz显卡NVIDIAGeForce8800ATIR...

- 手机离线单机游戏大全(10大单机离线手机游戏推荐)

-

①可能是因为以前的游戏在现在的手机等设备上不能运行了。或者说软件商没有对游戏的版本进行升级。以至于用户不能对其进行下载和使用。②以前的老游戏可能是因为质量粗糙等问题,使得用户的第一印象不好。失去了对其...

- 免费自制游戏app软件(如何自己开发一款游戏)

-

1、下个古或仔传奇服务端,下一个DBC2000,服务端里面有详细的安装说明。2、使用手机功能表中自带的浏览器上网,直接搜索需要的软件进行下载安装(下载安卓版本格式为apk)。3、需要绘图软件、3D制作...

- 刀剑神域游戏系列(刀剑神域神作)

-

刀剑神域无线时刻,是psp的游戏,不过手机装上psp模拟器也能玩这种游戏机现在还不能开发出来刀剑神域里的这个游戏机是通过阻断大脑神经,与游戏世界相连通进行游玩的现在的科技技术还打不到...

- 一周热门

- 最近发表

- 标签列表

-