真三国无双5安卓版下载(真三国无双5安卓版下载安装)

alicucu 2026-01-25 15:12 2 浏览

您好,真三国无双5手机游戏可以从应用商店中下载安装。您可以先打开手机应用商店,搜索“真三国无双5”关键词,找到与之相关的游戏应用,然后进行下载和安装。在下载和安装的过程中,请注意网络连接稳定,保证下载过程不中断。另外,建议在下载前先了解一下设备的存储空间和系统要求,确认游戏可以正常运行。

您好,真三国无双5手机游戏可以从应用商店中下载安装。您可以先打开手机应用商店,搜索“真三国无双5”关键词,找到与之相关的游戏应用,然后进行下载和安装。在下载和安装的过程中,请注意网络连接稳定,保证下载过程不中断。另外,建议在下载前先了解一下设备的存储空间和系统要求,确认游戏可以正常运行。

今天给大家讲讲,关于“真三国无双怎么下载?”,请看下面。

1、首先用电脑打开一个空白的网页,在搜索栏里面输入真三国无双4下载,然后回车。

2、此时会搜索出来很多个,我们选择第一个进去。

3、点击进去以后,我们找到下载列表,点击下载。

4、此时电脑就开始进行下载,我们等待下载完成。

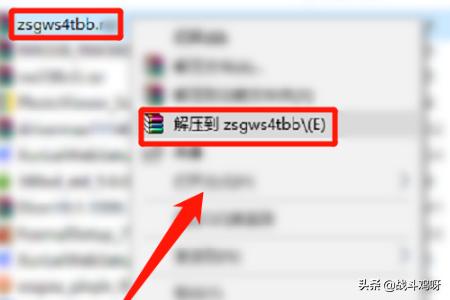

5、最后我们找到下载完成的程序,进行解压操作,安装即可。

相关推荐

- 单机没网也能玩的手机游戏(没网时候玩的单机游戏)

-

逃出银河系这是一款以海上逃生为题材的策略生存角色扮演游戏。玩家在游戏中的主要任务就是乘坐小木筏漂浮在海上,并且利用钩子来获取各种资源。值得注意的是游戏前期的资源是比较容易获得的,后期难度会慢慢增加。简...

- 宝可梦剑盾游戏下载手机版(宝可梦剑盾手机版免费下载)

-

要安装宝可梦剑盾手机版,首先需要确保你的手机系统是兼容的,然后前往应用商店(如AppStore或GooglePlay)搜索“宝可梦剑盾”。找到合适的应用后,点击下载并等待安装完成。一旦安装完成,用...

- 红警3命令与征服下载(红警三命令与征服下载)

-

你用的Win7系统吧?用注册表修复工具修复一下就好了。在开始菜单里红警3文件夹下有个“语言切换器-序列号切换器-注册表修复”图标,打开,随便设定一种语言就好了。在红色警戒3命令与征服中,您可以使用以下...

- 鬼泣5在steam叫什么(鬼泣5是哪个平台的游戏)

-

官方透露,鬼泣5将于2012年2月发售。官方给的就是最准确的,并没有精确到某一日,这又不是电影上映,计划赶不上变化嘛,官方总要给自己留一点余地,万一出什么变故好推迟一点时间。。。。鬼泣5一共具有2...

- 十大画质超高的古风手游(画质好的古风手游)

-

太简单了,首先,演那个美人的一定要是很漂亮的女演员才行。推荐《六指琴魔》《倩女幽魂》《青蛇》,都是林青霞张曼玉演的,两个字—完美

- 使命召唤k6冰龙免费领取(使命召唤战区冰龙皮肤多少钱)

-

k6冰龙的配置为:搭载马勒ebikemotion电助力系统,拥有250W的后花鼓电机,可提供40N·m的扭矩,最高助力速度为25km/h,高于这个速度后不再提供助力。36V7Ah的内置电池封装在车辆下...

- 仙剑3外传问情篇详细图文攻略

-

仙三外传和仙四不同,每个人都被系统预定了仙术,温慧是水,南宫煌火,星璇土,王蓬絮风,雷元戈雷。至于高级仙术,需要在低级仙术施展一定次数时才可出现。例如温慧,她在施展冰咒数次后,会出现水润这些辅...

- 2025cfm总决赛门票在哪买(cfml2021总决赛门票)

-

2024年的CFM赛事目前尚未公布具体开赛时间,通常是在每年夏季进行。赛事时间的确定与许多因素有关,如赛事筹备、参赛队伍的确定、赛事场地的可行性等。目前,组委会正在积极筹备,力争提供更加优质的赛事体验...

- 三国群英传单机破解版下载(三国群英传单机版 下载)

-

三国群英传一下载不了的原因是储存不足。根据查询相关公开信息显示,三国群英传没有版本限制,都可下载,内存不足可清理手机内存再进行下载。可能是游戏的服务器下架了,你可以在其他网页进行搜索下载如果您想下载三...

- 热血足球世界杯密码(热血足球怎么输入密码)

-

选定1P,2P后进入密码输入行上下移动调整数字,左右移动位置,输完按A选难度世界杯密码:F00000000800000019953334448888F99F99F999全...

- 英雄连手机版安卓版下载(英雄连手机版最新版)

-

配置需求《英雄连》需要5.2GB的可用空间、Android版本为9.0,并需在以下设备运行:?GooglePixel2或之后推出的机型?SamsungGalaxyS8或之后推出的机型?Sams...

- 好玩的即时战略游戏(好玩的即时战略游戏手游)

-

和之抗衡的有星际。其他的啊,红警,。帝国,命令与征服什么的,素质一般英雄无敌也是经典。。。黑暗十字军命令与征服3帝国时战代3亚洲王朝玩了没?自制战役和自制国家相当值得研究...

- 一周热门

- 最近发表

- 标签列表

-