孙侨潞医院吐白沫的视频(孙侨潞催吐多久)

alicucu 2025-12-21 21:47 2 浏览

孙侨潞没有在拍抖音了,只不过是别人借他的热度来蹭他热度而已他已经去世了

- 上一篇:三角形面积公式大全(三角形面积题100道)

- 下一篇:蒂怎么读(美乐蒂怎么读)

相关推荐

- 世界美女排行榜前一百(世界美女排行榜100名2019)

-

2021年即将进入尾声,美国网站TCCandler每年都会选出全球百大美女排行榜,如今官方名单出炉,今年的第一名是韩国女团BLACKPINK的成员Lisa,去年是第二名。EmilieNereng今...

-

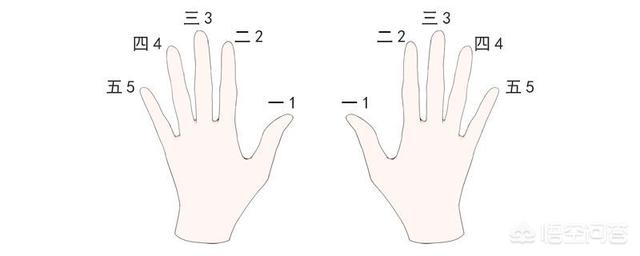

- 电子琴1234567指法图(1234567手势图)

-

尤克里里1234567的指法三弦空品是1,三弦二品是2,二弦空品是3,二弦一品是4,二弦三品是5,四弦空品也是5,一弦空品是6,四弦二品也是6,一弦二品是7。在弹奏尤克里里的时候要注意,手型是使用的古典手型,左手的一指左侧按琴弦,其余的手指...

-

2025-12-24 05:12 alicucu

- 长沙房产网(长沙房产网房天下)

-

长沙房地产公司排名1、湖南鑫远投资集团有限公司2、红星实业集团有限公司3、中建信和地产有限公司4、恒大地产集团长沙置业有限公司5、湖南保利房地产开发有限公司6、湖南天城置业发展有限公司7、长沙龙湖房地...

- 电子烟(电子烟有尼古丁吗)

-

电子烟是由中国人发明的,这个毋庸置疑。多数资料及实验显示。电子烟除尼古丁之外没有发现其他任何有害成分,对人体的不利影响也低于传统香烟。原材料不同:电子烟是微电子科技产品,有雾化器、锂电池和烟弹。目前市...

- 今年最流行的头发造型(今年最流行的头发造型和颜色)

-

时尚流行和个人喜好是选择头发颜色时需要考虑的因素,不过每年的流行趋势都会有所不同,以下列举几种近年来比较受欢迎的头发颜色:1.灰棕色:灰棕色是一种既低调又独特的中性色调,适合许多不同的肤色和发质,也非...

- 榴莲吃不完冷藏还是冷冻(榴莲冷冻的正确方法)

-

吃不完榴莲肉大多数可以冷冻,冷冻过后可能口感上会有一些差异,但是里面营养物质并不会流失,可以在吃时候解冻。但是避免长时间的冷冻,也会导致营养价值降低。榴莲的保存一般是冷冻比较好,而且可以存放的时间比较...

-

- 北京四达烂校211(北京四达国际)

-

没有最差的211之说,能被评为211大学都是有过硬的学术研究和科研能力。大学是教书育人的地方不是进行攀比名气的场所首先,北京语言大学身处首都,占据地理优势,另外这个学校虽然不是双一流学校,不是211学校,但是有些专业很不错,尤其是小语种,而...

-

2025-12-24 02:59 alicucu

- 龙的英文(龙的英文gala)

-

dragon读音:英[?dr?g?n]美[?dr?ɡ?n]n.龙,龙船;[D-][天文学]天龙(星座);[口语、贬义]脾气暴躁的人复数:dragons例句:1、Later,drag...

-

- 网线颜色顺序(网线颜色顺序水晶头)

-

网线颜色的顺序是有相应的标准的!TIA568B/568B就是!我们现在用的是TIA568B的标准!在以前的计算机网卡或是集线器,路由器,交换机等并不支持网线发送和接受的自动翻转!这就需要两个标准,同设备间做手动翻转来使两个设备可以通讯!比如...

-

2025-12-24 01:59 alicucu

- 芈月母亲向氏历史原型(芈月母亲向氏历史原型是谁)

-

芈月母亲向氏是莒姬宫里的媵女,因生育芈月被封为向夫人,后因生育芈戎被封为向妃。后来因为被王后趁大王不在诬陷她染上恶疾被赶出宫,被贱兵魏甲玷污,后来生下魏冉。大王回宫后接向妃回宫,为了给芈月芈戎换的好前...

- 天蝎座女生床上太可怕了(天蝎座女孩子床上的表现)

-

根据推断白羊配天蝎床会塌,这是根据星座之间的搭配得出的一种学说结论,因为白羊和天蝎两种人的性格是完全矛盾的,所以在结合之后会导致床塌

- 七情六欲代表什么意思(七情六欲什么意思呀)

-

七情六欲 七情,指一般人所具有之七种感情:喜、怒、忧、思、悲、恐、惊。六欲指眼、耳、鼻、舌、身、意六欲。 七情六欲,七情是指喜、怒、忧、思、悲、恐、惊。的感情表现或心理运动;六欲是指人的...

- 5级地震(吉林珲春市发生5.5级地震)

-

5级地震相当于477吨TNT炸药的威力,室内外多数人有感觉,熟睡的人会被震醒。门窗、屋顶、屋架颤动作响,灰土掉落,抹灰出现微细裂缝,有檐瓦掉落,个别屋顶烟囱掉砖,不稳定器物摇动或翻倒。地震的烈度第一级...

- 国民党五大主力(国民党五大主力排名)

-

抗日战场上五支国军的英雄部队抗日战争后,被重新命名组建的新编第一军、新编第六军〔简称新一军、新六军,下同〕、第五军、整编第七十四师〔整编前为七十四军〕、整编第十一师〔整编前为第十八军〕,是国民党的五...

- 浙江省内旅游景点推荐(浙江旅游攻略自由行最佳线路)

-

浙江旅游景点排名如下:1、杭州西湖西湖位于杭州城西,三面环山,东面濒临市区,是我国著名的旅游胜地,也被誉为“人间天堂”,是全国十大风景名胜之一,已被列入《世界遗产名录》。西湖古称“钱塘湖”,又名“西子...

- 一周热门

- 最近发表

- 标签列表

-