五一劳动节手抄报文字内容(五一劳动节手抄报文字内容大全)

alicucu 2025-12-21 21:48 1 浏览

可以画一些劳动节相关的画,再加上一些描述劳动人民的好段落。

以下是一些描写劳动人民的好段落:

劳动人民是世界上最伟大的人民,他们用劳动创造了世界,创造了人类,创造了我们今天的幸福生活。是劳动,建成了今天的万丈高楼;是劳动,筑就了现代化的信息高速公路;是劳动,让偌大的地球变成了一个小小的村落;是劳动,使浩翰的荒原变成了亩亩良田。劳动是神奇的,劳动是伟大的。

劳动者用勤劳的双手和智慧,编织了这个五彩班斓的世界,创造了人类的文明。让我们在这个特别的日子里,向全世界的劳动者致敬!在充满真情的五月,紧握你因劳动而开满茧花的手,送上我最真心的祝福,聆听你劳动的赞歌。

除此之外,还可以摘抄一些国家领导人关于劳动人民的话语,也是很有说服力的。

五一节手抄报资料:

五一节也就是劳动节。

劳动节必须劳动。平时不劳动的人,这一天也有义务要劳动;如果平时不好好劳动,干活的时候偷个懒啊、偷偷上个网啊什么的,那么这一天就必须好好劳动了。既然叫“劳动节”,顾名思义,那就得劳动,哪能休息呢?非但要劳动,而且还应当特别卖力地劳动,方能不辜负这个以“劳动”命名的特殊日子的意义。这就好比植树节那天大家都要去种树的意思。

延伸阅读:

春日渐去,趁天气晴好,邀四五朋友,游游山,玩玩水,共赏风景叙友谊;五一即来,值假期空闲,请七八同事,聊聊天,喝喝酒,畅谈人生度佳节。

五一问候十八弯,五一祝福九连环,祝你好运排对排,住进金银寨;愿你幸福串对串,拥有珠宝滩。朴实的情意,真诚心意,愿你一切都如意。

五一快乐!

- 上一篇:天王山之战的由来(天王山之战的历史)

- 下一篇:小g娜(小g娜与吴亦凡怎么认识的)

相关推荐

- 帮忙的拼音(帮忙的拼音怎样写的呀)

-

【词目】给予【拼音】jǐyǔ【英译】give;render;provide;confer【近义词】赐予、予以【反义词】接受、取得、索取【基本解释】使别人得到;给。答:应该读xì读jì...

- 新华字典 在线查字(新华字典 在线查字手写)

-

首先确定要查字的部首,数清部首笔画。依部首的笔画,可在「检字表」上找出本部首,并可看到其在「检字表」中的页码;数数除部首外,其余部分的笔画数,找出要查的字及笔画栏,并找出要查的字及其在字典正文中的页码...

-

- 奔跑的近义词(奔跑的近义词二年级)

-

"奔跑"的近义词有哪些?我的回答是:奔腾、驰骋、奔走、奔驰、飞跑。一、奔腾白话释义:原指马奔跑的样子朝代:现代作者:杨朔出处:诗的幻想却在我心里奔腾着。(:《西江月——井冈山写怀之二》)二、驰骋白话释义:可以形容骑马奔跑,驰骋原野朝代:清作...

-

2025-12-24 11:12 alicucu

- 郁达夫(郁达夫满江红)

-

郁达夫(1896.12.7~1945.9.17)原名郁文,字达夫,幼名阿凤,浙江富阳人,中国现代著名小说家、散文家、诗人。代表作有短篇小说集《沉沦》、小说《迟桂花》等。 郁达夫是现代著名作家。精...

- 奥迪a5敞篷二手车价格(奥迪a5敞篷二手车价格及图片)

-

当然可以卖,奥迪A5敞篷车是一款高端豪华车,有着出色的品质和性能,造型时尚,驾乘感受非常舒适。对于喜欢敞篷车款的消费者来说,这是一款非常吸引人的选择。对于卖家来说,如果车辆的整体情况和里程数符合市场需...

- cia和fbi哪个权力大(cia和fbi谁更牛)

-

确切来说这两个机构其实没有什么可比性,因为CIA隶属于国家安全委员会,主要任务是公开和秘密地收集外国政治、文化、科技等情报,协调国内各情报机构的活动,向总统和国家安全委员会提供报告。FBI是隶属于美...

- 好看的武打片(好看的武打片老电影推荐)

-

那个年代,不只是邵氏,嘉禾等公司的电影也都不错,我一起都列出来吧:独臂刀、刺马、水浒传、十三太保、十八般武艺、少林搭棚大师、残缺、五毒、三少爷的剑、天涯明月刀、多情剑客无情剑、马永贞、刺马、上海滩十三...

- 中国历史朝代时间表多少年(中国历史朝代年历表)

-

(1)大宋帝国:960年至1279年,存在时间长达320年,期间官员廉洁奉公,百姓富裕安乐,社会路不拾遗夜不闭户,堪称中国统治最长盛世最长的黄金时代。(2)大清帝国:1616年至1911年,存在295...

- 苏泊尔电饭煲e0故障(苏泊尔电饭煲e0故障维修视频)

-

显示e0是传感器开路故障。先拆开顶部检查温度传感器连接线是否断路,通常这个部件由于经常使用,而且材质都不好,导致温感器的连接线断裂。如果是线路断裂,则找一根相仿的电线连接断裂部分,并用电工胶带做好绝缘...

- 最恐怖的台风第一名(世界最恐怖的台风)

-

是威马逊台风。威马逊台风于2014年7月登陆我国的海南省文昌市,这个超强台风自登陆上岸后,就打破了之前2006年的桑美台风的记录,成为了我国建国以来强的超强台风,直接导致南宁这个城市发生海变,城市内部...

- 干燥剂有哪几种(食品干燥剂有哪几种)

-

1、酸性干燥剂:浓硫酸、P2O5、硅胶浓硫酸(强氧化性酸)、P2O5(酸性白色粉末)、硅胶(它是半透明,内表面积很大的多孔性固体,有良好的吸附性,对水有强烈的吸附作用。含有钴盐的硅胶叫变色硅胶,没有吸...

- 家用直饮水机(家用直饮水机十大名牌)

-

1、看直饮机是否有卫生许可证批件上所写的产品名字、型号要一致,因为即使在有证企业中,也存在“一证多用”的情况,即出现多个产品型号用一个卫生许可批件,消费者一定要查看清楚。2、看直饮机滤芯是否合适第一代...

- 滚筒洗衣机排行榜2025前十名

-

各有好处。1,上排水排的并不彻底,水泵处会有积水,要是放在特别冷的地方就需要在每次洗完衣服后动手给水泵排水。但也不会影响洗衣效果,因为有单向阀门限制水流向。但上排水在布置排水管时简单,上下都能排。2,...

- 世界美女排行榜前一百(世界美女排行榜100名2019)

-

2021年即将进入尾声,美国网站TCCandler每年都会选出全球百大美女排行榜,如今官方名单出炉,今年的第一名是韩国女团BLACKPINK的成员Lisa,去年是第二名。EmilieNereng今...

-

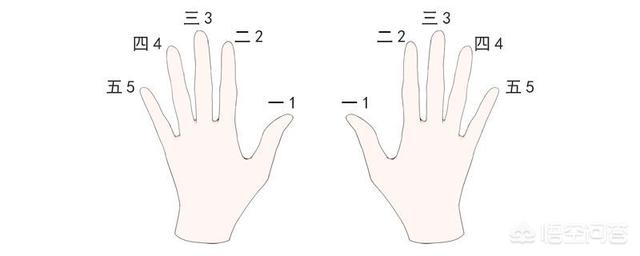

- 电子琴1234567指法图(1234567手势图)

-

尤克里里1234567的指法三弦空品是1,三弦二品是2,二弦空品是3,二弦一品是4,二弦三品是5,四弦空品也是5,一弦空品是6,四弦二品也是6,一弦二品是7。在弹奏尤克里里的时候要注意,手型是使用的古典手型,左手的一指左侧按琴弦,其余的手指...

-

2025-12-24 05:12 alicucu

- 一周热门

- 最近发表

- 标签列表

-